S'inscrire à la newsletter !

Restez à jour sur l’IA, abonnez-vous.

Restez à jour sur l’IA, abonnez-vous.

L’Intelligence Artificielle, ou IA, est aujourd’hui sur toutes les lèvres. On en parle dans les médias, les conférences, les entreprises… et elle s’invite même dans nos conversations du quotidien. Mais que se cache-t-il vraiment derrière cette expression ?

Des algorithmes qui recommandent nos séries préférées sur Netflix aux assistants vocaux qui nous rappellent nos rendez-vous, en passant par la traduction instantanée ou les applications qui détectent des anomalies sur des radiographies, l’IA est déjà partout. Pourtant, malgré sa présence grandissante, beaucoup d’entre nous n’en comprennent pas pleinement le fonctionnement ni les implications.

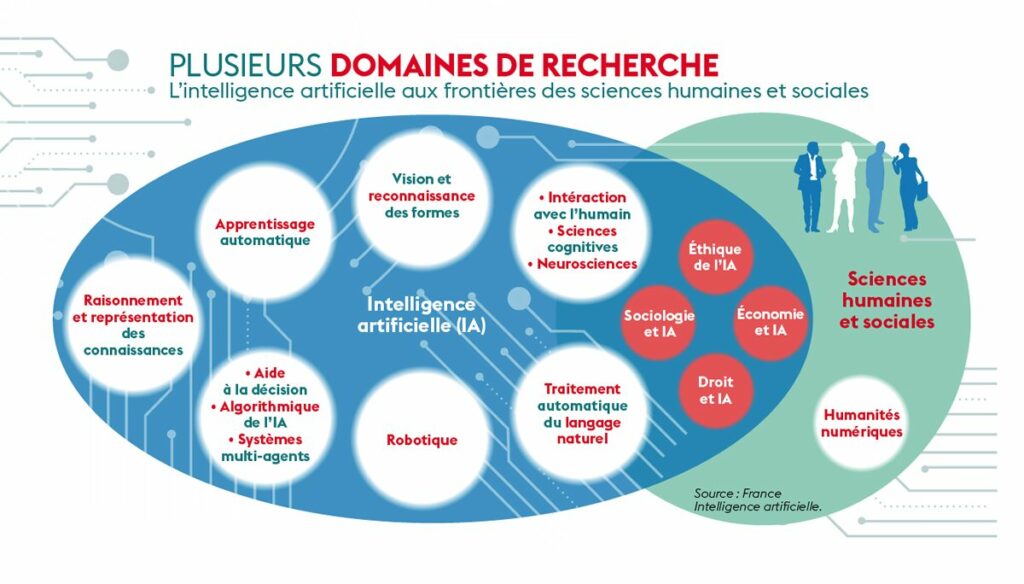

Pourquoi est-il essentiel de mieux comprendre l’IA aujourd’hui ? Parce qu’elle est en train de transformer nos métiers, nos industries, nos sociétés. Elle soulève des questions éthiques et réglementaires majeures, mais aussi des opportunités d’innovation et de performance inédites. Et surtout, parce qu’elle évolue rapidement, avec des avancées spectaculaires qui dessinent peu à peu le paysage technologique et économique de demain.

L’Intelligence Artificielle, ou IA, est un concept qui évoque souvent des images de robots autonomes ou d’ordinateurs « pensants ». Pourtant, sa réalité est plus simple et plus concrète. L’IA désigne la capacité d’un programme informatique ou d’un système à réaliser des tâches qui, normalement, nécessitent l’intelligence humaine. Je vous ai également rédigé un glossaire, si vous ne comprenez pas certains termes utilisé !

Ces tâches peuvent être très diverses : comprendre un texte, reconnaître une image, détecter une voix, prédire un résultat à partir de données, ou encore optimiser une chaîne logistique. Contrairement à ce que l’on pourrait penser, l’IA n’a pas de « conscience » : elle se contente d’exécuter des calculs et des traitements automatisés sur des données. Elle reproduit des schémas appris, sans les comprendre au sens humain du terme.

Pour mieux saisir cette idée, prenons une image simple : l’IA agit comme un outil bien programmé et entraîné, capable de réagir à des situations précises en fonction de ce qu’il a appris. Par exemple, un logiciel d’analyse d’images médicales peut identifier une tumeur sur une radiographie, non pas parce qu’il comprend ce qu’est une tumeur, mais parce qu’il a été entraîné à détecter certains motifs spécifiques dans des milliers d’exemples similaires.

Ainsi, l’IA peut être vue comme un mécanisme d’analyse et d’action automatisé, qui se base sur des données et des modèles mathématiques. Plus les données sont nombreuses et variées, plus le système peut être précis et performant.

L’Intelligence Artificielle est déjà bien ancrée dans notre quotidien. Elle se manifeste souvent sous des formes discrètes, mais elle est présente dans de nombreux services et outils que nous utilisons chaque jour.

Prenons quelques exemples concrets pour mieux comprendre :

Ces applications montrent que l’IA est omniprésente, même si nous ne la voyons pas toujours. Elle agit en arrière-plan pour rendre nos services plus efficaces, plus rapides et plus personnalisés.

L’Intelligence Artificielle se décline en deux grandes catégories, chacune correspondant à un niveau différent de complexité et de capacité d’adaptation. Cette distinction est essentielle pour bien comprendre ce que l’IA peut – et ne peut pas – faire aujourd’hui.

La première catégorie est celle de l’IA faible, également appelée IA étroite. Il s’agit d’un système conçu pour effectuer une seule tâche spécifique, dans un domaine bien délimité. Par exemple, un assistant vocal peut répondre à des questions simples, mais il ne pourra pas jouer aux échecs ou rédiger un texte. Cette IA est omniprésente dans notre quotidien et elle alimente la majorité des applications pratiques que nous connaissons :

La seconde catégorie, bien plus ambitieuse, est celle de l’IA forte, ou IA générale. Elle désigne un concept théorique d’un système capable d’apprendre et de s’adapter à n’importe quelle tâche, un peu comme un humain. Une telle IA pourrait passer d’un domaine à un autre sans nécessiter une reprogrammation spécifique : diagnostiquer une maladie le matin, piloter une voiture l’après-midi, et rédiger un roman le soir. Mais ce type d’IA n’existe pas encore. Elle est à ce jour l’objet de recherches et de spéculations, et elle soulève de nombreuses questions éthiques, technologiques et sociétales.

Il est donc important de bien distinguer ces deux approches : l’IA faible, que nous utilisons déjà largement, et l’IA forte, qui reste pour l’instant une perspective d’avenir.

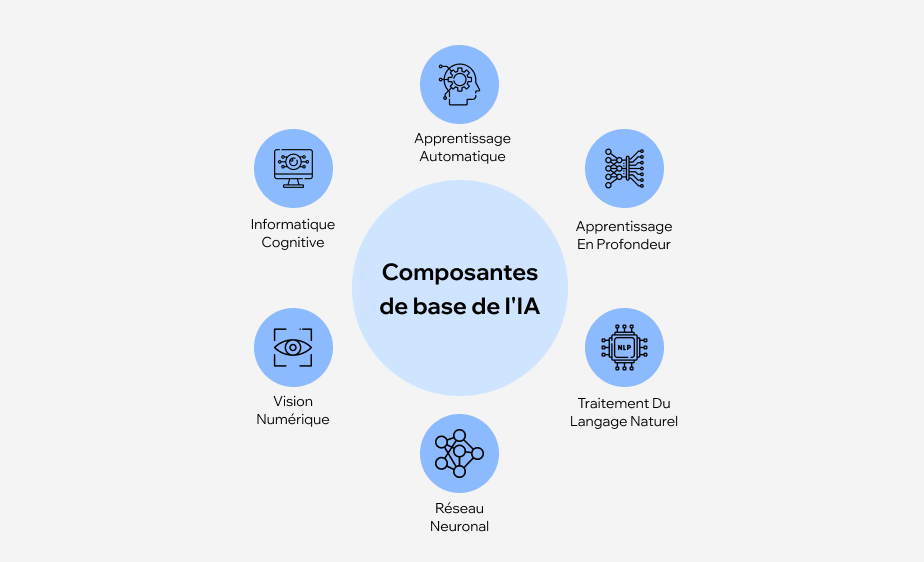

Pour mieux comprendre ce qui fait fonctionner l’Intelligence Artificielle, il est indispensable de se familiariser avec quelques concepts-clés, souvent techniques mais que l’on peut expliquer simplement.

L’apprentissage automatique est un sous-ensemble de l’IA qui permet à un programme de « s’améliorer tout seul » en apprenant à partir de données. Contrairement à un programme traditionnel, qui suit des instructions codées par un humain, le machine learning entraîne le programme à repérer des schémas et à prédire des résultats.

Prenons un exemple concret : imaginez que l’on montre à un logiciel des milliers d’images de chats et de chiens, en indiquant à chaque fois de quel animal il s’agit. Le programme va analyser les images et identifier des caractéristiques spécifiques (formes des oreilles, museau, pelage) qui distinguent les chats des chiens. Ensuite, lorsqu’on lui montre une nouvelle image, il pourra prédire si c’est un chat ou un chien, même sans avoir jamais vu cette image auparavant.

Le machine learning est utilisé dans des domaines variés : détection de fraude bancaire, filtrage de spams, reconnaissance faciale, recommandations sur les plateformes numériques…

Le deep learning est une forme plus avancée d’apprentissage automatique. Il repose sur des réseaux de neurones artificiels, inspirés du fonctionnement du cerveau humain. Ces réseaux sont capables de traiter des données complexes et de reconnaître des schémas subtils.

Imaginons un programme qui analyse la voix humaine. Grâce au deep learning, il peut identifier des sons, comprendre des mots, et même déduire le sens global d’une phrase. De la même façon, un programme de reconnaissance faciale utilisant le deep learning peut détecter un visage dans une foule ou vérifier une identité sur une photo.

Le deep learning a permis des avancées majeures dans des domaines comme :

Un algorithme est une suite d’instructions précises qu’un programme suit pour résoudre un problème. On peut le comparer à une recette de cuisine : chaque étape est définie pour arriver au résultat final.

Par exemple, un algorithme peut trier une liste de nombres du plus petit au plus grand, trouver le chemin le plus court entre deux points sur une carte, ou encore calculer le prix d’un produit en fonction de plusieurs critères. Dans le cadre de l’IA, l’algorithme est souvent combiné à des modèles d’apprentissage qui le rendent capable de s’adapter aux données qu’il reçoit.

Ces concepts sont les briques de base qui permettent à l’IA de fonctionner et d’évoluer. Pour ceux qui souhaitent approfondir ces notions, un excellent point de départ est l’article complet et accessible sur Wikipedia : Intelligence artificielle.

L’essor impressionnant de l’Intelligence Artificielle ces dernières années ne doit rien au hasard. Plusieurs facteurs clés expliquent cette accélération, qui transforme l’IA d’un concept théorique à une réalité omniprésente.

L’un des moteurs essentiels de cette progression est la disponibilité massive de données, souvent appelée big data. Chaque jour, nous générons d’énormes volumes d’informations : publications sur les réseaux sociaux, achats en ligne, consultations médicales, images, vidéos, et bien d’autres. Ces données constituent le « carburant » de l’IA. Plus un système a accès à de données variées et nombreuses, plus il peut apprendre et améliorer ses performances.

Un autre facteur déterminant est l’augmentation de la puissance de calcul. Les ordinateurs d’aujourd’hui sont capables de traiter des volumes colossaux d’informations en un temps record. Les progrès dans les technologies de processeurs, de cartes graphiques et de systèmes distribués ont permis à l’IA d’atteindre des niveaux de complexité et de rapidité inédits.

La recherche et le développement dans ce domaine ont également bénéficié de collaborations entre le monde académique et l’industrie. Des entreprises comme Google, Microsoft ou OpenAI investissent massivement dans la recherche sur l’IA, ce qui a conduit à des avancées spectaculaires : reconnaissance vocale, traduction automatique, modèles génératifs capables de produire du texte ou des images, etc.

Enfin, l’essor de l’IA s’appuie sur une demande croissante des secteurs économiques et publics. De nombreuses entreprises cherchent à automatiser des processus, optimiser la prise de décision ou améliorer l’expérience utilisateur. De leur côté, les gouvernements investissent dans l’IA pour moderniser les services publics, renforcer la cybersécurité ou anticiper les défis sociétaux.

Pour approfondir les raisons de cette progression, on peut consulter l’analyse du Stanford AI Index Report, qui fait chaque année le point sur les avancées, les tendances et les usages de l’IA dans le monde : Stanford AI Index.

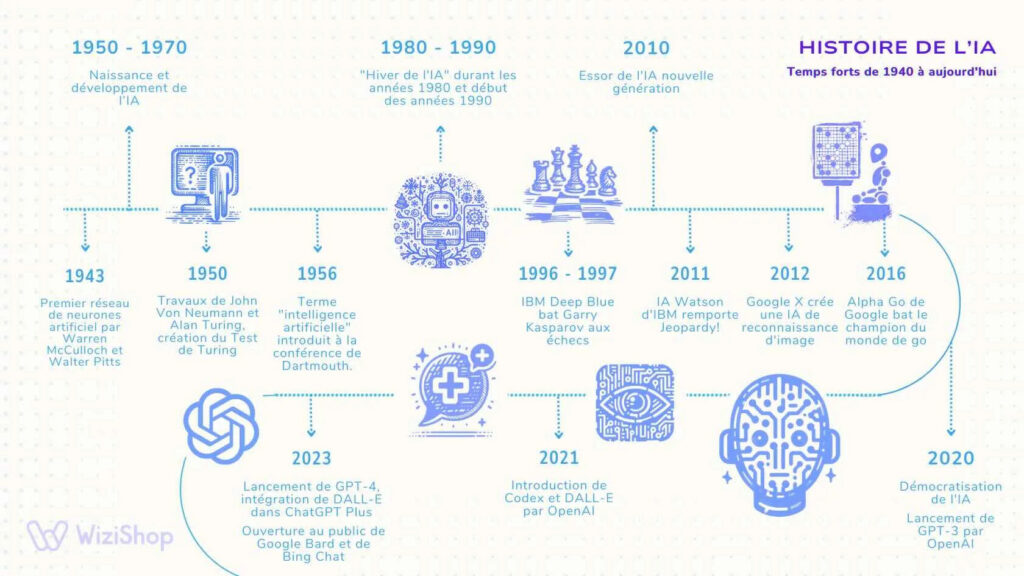

Pour bien comprendre ce qu’est l’Intelligence Artificielle aujourd’hui et anticiper son futur, il est indispensable de se plonger dans son histoire. L’IA ne s’est pas imposée du jour au lendemain : elle résulte de décennies de recherches, d’expérimentations, de succès mais aussi de revers.

En retraçant les étapes clés de cette évolution, on découvre une aventure scientifique et technologique fascinante, marquée par des percées majeures, des périodes d’euphorie et des phases de doute. Cette histoire est aussi celle d’une quête : celle de doter les machines d’une forme d’« intelligence » capable d’assister, de compléter voire de dépasser l’intelligence humaine.

Dans cette section, nous allons explorer les origines théoriques de l’IA, ses débuts prometteurs, ses « hivers » marqués par des déceptions, et son renouveau spectaculaire, jusqu’aux dernières innovations qui bouleversent nos sociétés. Cette plongée dans l’histoire de l’IA nous permettra de mieux comprendre ses fondements, ses évolutions et ses enjeux.

L’idée d’une machine capable de penser n’est pas née avec l’informatique moderne. Elle trouve ses racines dans des réflexions philosophiques et scientifiques bien antérieures à l’invention de l’ordinateur. Parmi les premiers à théoriser cette possibilité, Alan Turing, mathématicien et cryptologue britannique, joue un rôle central.

Dans son article publié en 1950, « Computing Machinery and Intelligence », Turing pose la célèbre question : « Les machines peuvent-elles penser ? ». Pour y répondre, il propose un test, désormais connu sous le nom de test de Turing. Ce test évalue la capacité d’une machine à se faire passer pour un humain dans une conversation. Si l’interlocuteur ne peut pas distinguer la machine de l’humain, alors la machine est considérée comme dotée d’une forme d’« intelligence .

Cette réflexion pose les bases de l’IA moderne en suggérant qu’une machine pourrait, grâce à un programme bien conçu, simuler l’intelligence humaine. Turing, qui a également contribué au développement des premiers ordinateurs, ouvre ainsi la voie à une réflexion sur les limites et les potentialités des machines.

Anecdote : on raconte que Turing, passionné de jeux et de logique, imaginait déjà des « machines pensantes » bien avant l’avènement des ordinateurs, en s’inspirant des énigmes et des stratégies de jeu. Cette approche ludique a marqué sa vision de l’IA.

Cette période des origines théoriques est marquée par une idée forte : si l’on peut décrire la pensée comme une suite d’instructions logiques, alors une machine pourrait, en théorie, les exécuter.

Si les origines théoriques de l’Intelligence Artificielle remontent aux réflexions d’Alan Turing, c’est en 1956, lors de la conférence de Dartmouth, que l’IA prend officiellement son envol. Cet événement, organisé par John McCarthy, marque la naissance de la discipline et fixe un objectif ambitieux : créer des machines capables d’apprendre et de raisonner comme des humains.

La conférence réunit plusieurs pionniers de l’IA, dont Marvin Minsky, Claude Shannon et Allen Newell. Ces chercheurs posent les bases théoriques et pratiques de l’IA moderne. Le terme « Artificial Intelligence » est d’ailleurs introduit par McCarthy à cette occasion, pour désigner la nouvelle discipline.

À cette époque, les premiers programmes symboliques apparaissent. L’un des plus connus est le Logic Theorist, développé par Newell et Simon. Ce programme est capable de démontrer des théorèmes logiques, imitant ainsi des processus cognitifs humains. Peu après, ELIZA, conçu par Joseph Weizenbaum, simule un psychothérapeute en générant des réponses textuelles à partir d’entrées fournies par l’utilisateur. Ces programmes montrent que des machines peuvent « imiter » des comportements intelligents, même s’ils restent très basiques.

La conférence de Dartmouth et ces premiers programmes posent les fondations de l’IA, en associant recherche théorique et expérimentations pratiques. À cette époque, l’optimisme est de mise : beaucoup pensent qu’une IA comparable à l’intelligence humaine sera réalisable en quelques décennies.

Pour approfondir cette période fondatrice, vous pouvez consulter l’article détaillé sur Wikipedia : Histoire de l’intelligence artificielle.

Après les débuts prometteurs de la conférence de Dartmouth, l’IA connaît une phase d’expansion dans les années 1960 et 1970. De nombreux chercheurs et laboratoires se lancent dans le développement de systèmes symboliques, capables de traiter des règles logiques et des connaissances formelles. L’enthousiasme est à son comble : on imagine des machines capables de résoudre des problèmes complexes, de comprendre le langage naturel et même de dialoguer avec les humains.

C’est dans cette période que des projets emblématiques voient le jour :

Cependant, cette effervescence est freinée par des obstacles majeurs. Les ordinateurs de l’époque manquent de puissance de calcul, les modèles symboliques peinent à gérer l’incertitude et la complexité du monde réel, et les bases de connaissances restent limitées.

Ces difficultés conduisent à ce qu’on appelle les « hivers de l’IA ». Entre les années 1970 et le début des années 1990, le financement de la recherche sur l’IA chute drastiquement, et les espoirs d’une IA généralisée s’évanouissent. Les promesses initiales n’ont pas été tenues, et l’industrie se tourne vers d’autres priorités.

Anecdote : dans ces périodes de désillusion, certains chercheurs continuent à explorer discrètement des pistes novatrices, comme l’apprentissage automatique, sans savoir qu’ils jetteront les bases du renouveau à venir.

Pour comprendre pourquoi l’IA a traversé ces hivers, on peut se référer à des analyses rétrospectives .

Après les périodes de désillusion, l’IA connaît un véritable renouveau dans les années 1990 et 2000. Cette renaissance est portée par plusieurs évolutions majeures, à commencer par le développement du machine learning, ou apprentissage automatique. Plutôt que de programmer explicitement chaque règle ou scénario, les chercheurs se tournent vers des méthodes où l’IA apprend à partir des données.

L’une des avancées marquantes est l’émergence de l’apprentissage profond, ou deep learning, qui utilise des réseaux de neurones artificiels pour traiter des données complexes. Grâce à l’augmentation des puissances de calcul et à la disponibilité croissante de données massives (big data), ces réseaux peuvent reconnaître des motifs subtils et produire des résultats impressionnants.

Cette période voit également l’arrivée d’applications concrètes :

Anecdote marquante : en 1997, l’ordinateur Deep Blue d’IBM bat le champion du monde d’échecs Garry Kasparov. Cet événement médiatique montre que l’IA est capable de rivaliser avec l’expertise humaine dans des domaines très complexes.

Depuis le début des années 2010, l’Intelligence Artificielle connaît un essor spectaculaire qui transforme non seulement les technologies mais aussi nos modes de vie, nos métiers et nos sociétés. Cette révolution est portée par trois facteurs essentiels : l’explosion des données disponibles, les avancées technologiques (notamment dans les processeurs graphiques) et le perfectionnement des algorithmes, en particulier dans le domaine du deep learning.

L’émergence de modèles massifs d’IA a permis d’atteindre des performances inégalées dans des domaines variés. Parmi les exemples marquants :

Ces innovations montrent que l’IA ne se limite plus à exécuter des tâches simples : elle peut désormais produire du contenu original, explorer des solutions complexes et interagir avec les humains de manière fluide et contextuelle.

Cette période est également marquée par une démocratisation des outils IA : grâce aux plateformes cloud et aux logiciels accessibles, même les petites entreprises et les particuliers peuvent exploiter ces technologies. Cela ouvre des perspectives inédites mais soulève aussi des questions éthiques et sociétales majeures, notamment sur la transparence, les biais, et l’impact sur l’emploi.

L’évolution de l’Intelligence Artificielle ne montre aucun signe de ralentissement. Au contraire, les prochaines années promettent d’être marquées par des avancées encore plus spectaculaires. Mais ces progrès ne vont pas sans soulever des questions technologiques, éthiques et économiques cruciales.

D’un point de vue technologique, les chercheurs explorent de nouvelles voies pour améliorer les performances et l’autonomie des systèmes IA. On parle notamment de modèles hybrides associant différentes approches (symbolique et apprentissage profond) ou de l’essor des modèles multimodaux, capables de traiter simultanément texte, images et son. L’objectif est de concevoir des systèmes plus flexibles, capables de raisonner dans des contextes variés et de comprendre des situations complexes.

Les perspectives économiques sont également immenses. L’IA s’impose comme un levier stratégique pour les entreprises, offrant des gains de productivité, de nouvelles opportunités d’innovation et une personnalisation accrue des services. Toutefois, son adoption pose des questions d’investissement, de formation des équipes et de transition des métiers.

Sur le plan éthique et social, l’essor de l’IA soulève des débats majeurs :

De nombreux experts et institutions (comme le Forum économique mondial ou la Commission européenne) insistent sur la nécessité de mettre en place un encadrement réglementaire solide, pour garantir un développement responsable et éthique de l’IA.

Pour beaucoup, l’Intelligence Artificielle reste une boîte noire : on sait qu’elle prend des décisions et réalise des tâches complexes, mais on ne comprend pas toujours comment. Pourtant, il est essentiel de percer ce mystère pour mieux apprécier son potentiel et ses limites.

Le fonctionnement de l’IA repose sur un enchaînement précis de mécanismes : des algorithmes qui dictent les règles, des données qui alimentent le système, et des modèles d’apprentissage qui permettent à l’IA de s’adapter et d’évoluer. En comprenant ces concepts de base, on découvre que l’IA n’a rien de magique : c’est une construction logique et mathématique, capable de transformer d’immenses volumes d’informations en décisions concrètes.

Dans cette section, nous allons explorer ces fondements avec des exemples concrets et accessibles, pour que chacun puisse saisir comment une IA fonctionne réellement.

Le cœur du fonctionnement de l’Intelligence Artificielle repose sur trois piliers : les algorithmes, les données et les modèles d’apprentissage. Chacun joue un rôle indispensable dans le processus.

Commençons par les algorithmes. Ce sont des suites d’instructions précises que l’ordinateur exécute pour résoudre un problème. On peut les comparer à une recette de cuisine : chaque étape est définie à l’avance pour arriver à un résultat précis. Dans l’IA, ces algorithmes permettent de traiter les données, d’identifier des motifs ou de faire des prédictions.

Viennent ensuite les données. Sans elles, l’IA ne peut rien faire. Imaginez que l’on veuille entraîner un système à reconnaître des photos de chiens. Il faut lui fournir des milliers, voire des millions d’images, accompagnées de la mention « chien » ou « pas chien ». Plus le volume de données est grand et varié, plus le système pourra apprendre efficacement.

Enfin, le modèle d’apprentissage est le produit final : c’est le système « entraîné » qui a appris à résoudre une tâche en s’appuyant sur les algorithmes et les données. Une fois entraîné, ce modèle peut être utilisé pour analyser de nouvelles données et prendre des décisions. Par exemple, il pourra reconnaître un chien sur une nouvelle photo jamais vue auparavant.

En résumé, on peut voir l’IA comme une cuisine bien rodée :

C’est en combinant ces trois éléments que l’IA peut apprendre, s’améliorer et fournir des résultats pertinents.

L’apprentissage est au cœur du fonctionnement de l’IA. Mais il ne s’agit pas d’un seul processus : il existe plusieurs types d’apprentissage, chacun adapté à des besoins spécifiques.

Le plus courant est l’apprentissage supervisé. Ici, le système est entraîné avec des exemples annotés. Prenons un exemple : on fournit à l’IA des milliers d’images de chats et de chiens, en indiquant pour chaque image de quel animal il s’agit. L’algorithme apprend à repérer des caractéristiques spécifiques et à les associer à la bonne catégorie. Une fois entraîné, le modèle pourra reconnaître un chat ou un chien sur une nouvelle image. Cette méthode est largement utilisée dans des domaines comme la reconnaissance d’image, la détection de fraude bancaire, ou encore la prédiction de ventes.

Ensuite, il y a l’apprentissage non supervisé. Dans ce cas, les données ne sont pas étiquetées. L’IA reçoit un ensemble d’informations et doit trouver des structures ou des regroupements par elle-même. C’est un peu comme donner à l’IA des photos d’animaux sans lui dire lesquels sont des chats ou des chiens : elle va analyser les images et tenter de créer des groupes homogènes. Cette approche est utilisée pour la segmentation de clientèle, la détection de tendances ou l’analyse exploratoire de données.

Enfin, l’apprentissage par renforcement est une approche inspirée de l’apprentissage humain. Ici, l’IA interagit avec un environnement et apprend par essai-erreur, en recevant des « récompenses » ou des « pénalités » selon ses actions. Imaginez un robot qui apprend à marcher : il teste différentes actions et reçoit une récompense quand il avance et une pénalité quand il tombe. Progressivement, il apprend à marcher correctement. Ce type d’apprentissage est utilisé dans des domaines comme la robotique, les jeux (AlphaGo) ou la conduite autonome.

Chacune de ces approches a ses spécificités et ses domaines d’application. Souvent, elles sont combinées pour concevoir des systèmes plus performants et adaptés à des situations complexes.

Pour des définitions plus détaillées, vous pouvez consulter les articles dédiés sur Wikipedia : Apprentissage supervisé, Apprentissage non supervisé, Apprentissage par renforcement.

Pour mieux comprendre le fonctionnement de l’IA, prenons un scénario simple mais parlant : comment une IA est-elle capable de reconnaître un chat sur une photo ?

Tout commence par la collecte des données. Des milliers, voire des millions, d’images contenant des chats sont rassemblées. Chaque image est annotée avec l’information « chat ». Plus le jeu de données est riche et varié (photos sous différents angles, avec des races variées, en intérieur et en extérieur), plus le modèle pourra apprendre à généraliser.

Ensuite, un algorithme d’apprentissage supervisé est choisi. L’un des plus utilisés dans ce type de tâche est le réseau de neurones convolutif (CNN), une architecture particulièrement adaptée à l’analyse d’images. Ce réseau va traiter chaque image en la décomposant en petites zones, en repérant des motifs comme les contours, les textures, les formes des oreilles, les yeux ou la queue.

Le modèle est ensuite entraîné sur ces images annotées. Il ajuste progressivement ses paramètres internes (appelés poids) pour minimiser les erreurs, c’est-à-dire les cas où il ne reconnaît pas un chat ou identifie à tort un autre objet comme un chat.

Une fois l’apprentissage terminé, le modèle peut être testé sur de nouvelles images, qu’il n’a jamais vues. S’il a bien appris, il sera capable de prédire, avec un haut degré de fiabilité, si une nouvelle photo contient un chat ou non.

Cet exemple illustre bien comment l’IA :

C’est ce même principe qui est utilisé dans des applications variées, de la détection de visages sur les smartphones à l’analyse d’imageries médicales, en passant par la reconnaissance automatique d’objets dans des vidéos.

L’Intelligence Artificielle repose sur une vérité simple : pas de données, pas d’IA. Les algorithmes, aussi sophistiqués soient-ils, ne peuvent rien apprendre sans matière première. Et cette matière première, c’est la donnée.

Chaque fois qu’un système IA apprend à reconnaître un visage, à traduire un texte ou à suggérer un produit, il le fait en se basant sur d’énormes ensembles de données. Plus ces ensembles sont riches, variés et bien structurés, plus l’IA peut développer des modèles précis et performants. C’est pourquoi on dit souvent que les données sont le carburant qui alimente l’IA.

Cependant, toutes les données ne se valent pas. La qualité et la diversité des données sont primordiales. Si le jeu de données est biaisé (par exemple, s’il contient majoritairement des images de chats blancs), l’IA risque de mal généraliser et de commettre des erreurs. C’est ce que l’on appelle le biais de données, un problème majeur dans l’IA moderne.

L’essor du big data – la disponibilité de volumes massifs de données générés par nos activités numériques – a permis à l’IA de progresser de manière spectaculaire. Mais cela soulève aussi des questions importantes sur la collecte, l’éthique et la protection des données personnelles.

L’Intelligence Artificielle n’est plus confinée aux laboratoires de recherche ou aux entreprises technologiques : elle est désormais présente dans presque tous les secteurs d’activité. Des soins de santé aux finances, en passant par le commerce, la mobilité, l’industrie et même nos loisirs, l’IA transforme les façons de travailler, de produire et d’interagir.

Ce déploiement rapide n’est pas le fruit du hasard. Il résulte des progrès techniques majeurs des dernières décennies, mais aussi de la reconnaissance, par les entreprises et les institutions, du potentiel énorme de l’IA pour améliorer l’efficacité, la qualité et la personnalisation des services.

Dans cette section, nous allons explorer les principaux domaines d’application de l’IA, en illustrant chaque secteur par des exemples concrets et des anecdotes pour rendre cette exploration vivante et accessible.

Le domaine de la santé est l’un des secteurs où l’Intelligence Artificielle a apporté les changements les plus spectaculaires. Grâce à l’analyse de grandes quantités de données médicales et à des algorithmes avancés, l’IA contribue à améliorer le diagnostic, le traitement et la prise en charge des patients.

Un exemple frappant est l’utilisation de l’IA dans l’imagerie médicale. Des algorithmes de deep learning peuvent analyser des radiographies, des IRM ou des scanners pour détecter des anomalies, comme des tumeurs ou des fractures, souvent plus rapidement et parfois plus précisément qu’un radiologue humain. Ces systèmes sont déjà utilisés dans des hôpitaux et centres de diagnostic à travers le monde.

L’IA joue également un rôle clé dans la recherche de nouveaux médicaments. En simulant le comportement des molécules et en prédisant leur efficacité, elle permet de raccourcir le temps nécessaire au développement de traitements et de réduire les coûts.

Un autre domaine d’application est l’assistance au suivi des patients. Des chatbots et assistants virtuels, souvent alimentés par des modèles IA, peuvent répondre aux questions des patients, rappeler la prise de médicaments ou alerter en cas de symptômes inhabituels.

Anecdote marquante : lors d’une étude menée par des chercheurs en Chine et aux États-Unis, un système d’IA a réussi à diagnostiquer certains cancers plus tôt que les médecins, en identifiant des signes invisibles à l’œil nu sur les scanners pulmonaires

Le secteur financier a rapidement compris l’intérêt stratégique de l’Intelligence Artificielle. Dans un domaine où les volumes de données sont colossaux et les enjeux économiques majeurs, l’IA permet d’optimiser les prises de décision, de sécuriser les transactions et d’améliorer l’expérience client.

L’un des usages les plus connus est la détection des fraudes. Grâce à des algorithmes d’apprentissage automatique, les banques et institutions financières analysent en temps réel des millions de transactions pour repérer les comportements inhabituels. Lorsqu’un schéma suspect est identifié (par exemple, un paiement à l’étranger d’un montant inhabituel), l’IA peut déclencher une alerte et bloquer la transaction, limitant ainsi les pertes financières.

Dans la gestion de portefeuilles, l’IA contribue à l’automatisation des investissements. Des « robo-advisors », ou conseillers automatisés, proposent des stratégies d’investissement adaptées au profil de l’utilisateur, en analysant les tendances du marché et les données historiques. Ces systèmes sont capables d’ajuster les allocations en fonction des fluctuations économiques, sans intervention humaine directe.

L’IA est aussi exploitée pour l’analyse prédictive des marchés financiers. En combinant des données économiques, géopolitiques et sectorielles, elle peut anticiper les évolutions des cours et proposer des recommandations. Bien que ces prédictions ne soient pas infaillibles, elles offrent un avantage stratégique aux institutions qui les utilisent.

Ces technologies soulèvent également des enjeux éthiques : comment garantir la transparence des décisions prises par l’IA ? Comment protéger les données personnelles des clients ? Autant de questions auxquelles le secteur financier doit répondre pour maintenir la confiance des utilisateurs.

Le marketing et le commerce en ligne sont des domaines où l’Intelligence Artificielle a eu un impact rapide et massif. Grâce à l’analyse des données clients et à la personnalisation des interactions, l’IA permet aux entreprises de mieux cibler leurs publics et d’optimiser leurs stratégies commerciales.

Un exemple très concret est celui des recommandations personnalisées. Des plateformes comme Amazon ou Netflix analysent les historiques d’achat ou de visionnage de leurs utilisateurs pour suggérer des produits ou des contenus susceptibles de les intéresser. Ces recommandations sont générées par des algorithmes d’apprentissage automatique capables de repérer des schémas de préférences parmi des millions d’utilisateurs.

L’IA joue aussi un rôle essentiel dans l’optimisation des campagnes publicitaires. En analysant les comportements des internautes, leurs interactions avec les contenus et les tendances du moment, elle ajuste en temps réel les paramètres des campagnes (ciblage, budget, message) pour maximiser leur efficacité et leur retour sur investissement.

Autre application : les chatbots, ces agents conversationnels qui assistent les clients sur les sites e-commerce. Grâce à l’IA, ils peuvent répondre à des questions fréquentes, aider à la navigation, ou même suggérer des produits, 24 heures sur 24.

Ces avancées offrent des avantages concurrentiels importants, mais elles posent aussi des défis : respect de la vie privée, qualité des recommandations, ou encore protection contre les manipulations et les biais algorithmiques.

L’Intelligence Artificielle transforme en profondeur le secteur des transports et de la mobilité, en rendant les systèmes plus sûrs, plus fluides et plus intelligents.

L’une des applications les plus spectaculaires est celle des véhicules autonomes. Grâce à des capteurs, des caméras et des algorithmes sophistiqués, ces voitures peuvent analyser leur environnement, détecter les obstacles, prévoir les mouvements des autres véhicules et prendre des décisions en temps réel. Des entreprises comme Waymo, Tesla ou Baidu testent déjà ces technologies sur route, ouvrant la voie à une mobilité plus autonome et plus accessible.

Dans le domaine de la logistique, l’IA est utilisée pour optimiser les itinéraires et la chaîne d’approvisionnement. Elle analyse les conditions de circulation, les prévisions météorologiques, les niveaux de stock et d’autres facteurs pour proposer les trajets les plus courts et les plus efficaces. Cela permet de réduire les coûts et l’empreinte carbone des livraisons.

L’IA est également exploitée pour gérer le trafic et prévoir les congestions dans les zones urbaines. Des systèmes intelligents ajustent les feux de signalisation, identifient les zones à risque et orientent les flux de circulation en fonction des besoins.

Ces innovations promettent de révolutionner la façon dont nous nous déplaçons, mais elles posent aussi des défis en termes de sécurité, de réglementation et d’acceptabilité sociale.

Dans le secteur industriel, l’Intelligence Artificielle est devenue un levier incontournable pour améliorer la productivité, la qualité et la sécurité des processus de fabrication.

Une application majeure est la maintenance prédictive. Grâce à des capteurs et à l’analyse de données en temps réel, l’IA peut détecter les signes précurseurs d’une panne ou d’un dysfonctionnement. Par exemple, un algorithme peut analyser les vibrations d’un moteur ou la température d’une machine et alerter les techniciens avant qu’une défaillance ne survienne. Cela permet de limiter les arrêts de production, de réduire les coûts de maintenance et d’optimiser l’utilisation des équipements.

L’IA contribue également à l’automatisation de la production. Des robots intelligents, dotés de capteurs et d’algorithmes d’apprentissage, peuvent assembler des pièces complexes, ajuster leur position en fonction des variations des matériaux et même collaborer avec des opérateurs humains. Cette approche, souvent désignée sous le terme d’industrie 4.0, combine robotique avancée, IoT et IA pour créer des usines plus intelligentes et flexibles.

Enfin, l’IA est exploitée dans les contrôles qualité automatisés. Des systèmes de vision industrielle analysent les produits à la sortie des lignes de production, détectant les défauts ou les non-conformités avec une précision et une rapidité inégalées.

Ces applications montrent que l’IA est bien plus qu’un gadget dans l’industrie : elle en est déjà un rouage essentiel.

L’Intelligence Artificielle joue un rôle croissant dans la transformation des services publics et dans la gestion des enjeux environnementaux. En exploitant des volumes massifs de données et en automatisant des tâches complexes, elle contribue à rendre les services plus efficaces, plus sûrs et plus durables.

Dans le domaine de la gestion des catastrophes naturelles, l’IA est utilisée pour prédire les événements extrêmes (inondations, incendies, tremblements de terre) et anticiper leur impact. Des algorithmes analysent en temps réel des données satellites, météorologiques et géographiques pour émettre des alertes précoces et guider les interventions d’urgence.

L’IA contribue aussi à l’amélioration de la qualité de l’air et à la réduction des consommations d’énergie. Dans certaines villes, des systèmes intelligents ajustent le fonctionnement des réseaux électriques ou des infrastructures urbaines en fonction de la demande et des conditions environnementales, réduisant ainsi l’empreinte carbone.

En matière de gestion des réseaux publics (eau, électricité, transport), l’IA optimise l’utilisation des ressources, détecte les anomalies et propose des solutions pour améliorer l’efficacité. Ces avancées permettent non seulement de mieux servir les usagers mais aussi de protéger l’environnement.

Ces initiatives s’inscrivent dans une tendance plus large : celle d’une IA au service du bien commun, capable de répondre à des défis collectifs tout en respectant les contraintes économiques et sociales.

L’Intelligence Artificielle ne se limite pas aux domaines professionnels ou stratégiques : elle s’invite aussi dans nos vies personnelles et nos loisirs. Elle rend nos expériences plus fluides, plus personnalisées et souvent plus divertissantes.

Un exemple emblématique est celui des assistants vocaux. Que ce soit Siri, Alexa ou Google Assistant, ces outils utilisent l’IA pour comprendre nos requêtes, y répondre de manière pertinente et parfois même anticiper nos besoins (par exemple, programmer un rappel ou ajuster les paramètres domotiques de la maison).

Dans le domaine du divertissement, l’IA est omniprésente :

L’IA est également présente dans la domotique, transformant nos maisons en espaces intelligents : thermostats connectés, éclairages automatiques, systèmes de sécurité prédictifs… tout cela fonctionne grâce à des algorithmes capables d’apprendre nos habitudes et de les reproduire.

Ces usages montrent que l’IA ne se contente pas d’optimiser les industries : elle enrichit aussi notre quotidien, en simplifiant les interactions et en personnalisant les expériences.

Un exemple spectaculaire d’application de l’Intelligence Artificielle est celui des systèmes de diagnostic médical assisté par IA.

En 2020, une équipe internationale de chercheurs a mis au point un algorithme capable de détecter le cancer du sein sur des mammographies avec une précision supérieure à celle des radiologues humains. Ce système a été entraîné sur des centaines de milliers d’images et a appris à repérer des anomalies souvent invisibles à l’œil nu. Résultat : un diagnostic plus rapide, plus fiable, et une réduction des risques d’erreurs médicales.

Un autre cas marquant est celui d’IDx-DR, un logiciel approuvé par la FDA aux États-Unis pour le dépistage autonome de la rétinopathie diabétique. Ce dispositif analyse des images de la rétine et alerte le patient et le médecin en cas d’anomalie, sans qu’un ophtalmologiste doive examiner les clichés.

Ces exemples montrent que l’IA peut véritablement changer la donne dans la santé, en complétant le travail des professionnels et en améliorant l’accès aux soins, surtout dans les régions sous-médicalisées.

L’Intelligence Artificielle fascine autant qu’elle inquiète. D’un côté, elle offre des perspectives incroyables pour améliorer la productivité, la qualité de vie et l’innovation ; de l’autre, elle soulève des questions éthiques, sociales et techniques.

L’IA permet de gagner du temps et d’optimiser les processus. Dans l’industrie, elle automatise des tâches répétitives, détecte les pannes avant qu’elles ne se produisent et réduit les coûts. Dans les services, elle personnalise les expériences clients et fluidifie les interactions.

En santé, elle peut améliorer la précision des diagnostics et accélérer la recherche médicale. Dans les transports, elle contribue à la sécurité et à l’optimisation des flux. Dans l’éducation, elle ouvre de nouvelles perspectives pour l’apprentissage personnalisé.

L’IA est aussi un levier d’innovation, en rendant possible ce qui était inimaginable auparavant : analyses de données massives en quelques secondes, conception de nouveaux matériaux, prévisions économiques plus fiables…

Mais l’IA a aussi ses limites. Sa performance dépend étroitement de la qualité des données sur lesquelles elle est entraînée. Si ces données sont biaisées ou incomplètes, le système reproduira ces biais, voire les amplifiera. Par exemple, un algorithme de recrutement pourrait écarter certains profils s’il a été entraîné sur des historiques discriminants.

L’opacité des algorithmes complexes, notamment ceux du deep learning, pose des problèmes de transparence. Comment expliquer une décision prise par une IA ? Comment garantir qu’elle est juste et conforme à l’éthique ? Ces questions sont au cœur des débats sur la responsabilité et la réglementation.

L’IA soulève aussi des inquiétudes sur l’emploi. Si elle peut libérer les humains de certaines tâches répétitives, elle risque aussi de remplacer certains métiers. Il est crucial d’anticiper ces transformations et de repenser la formation et l’organisation du travail.

Enfin, l’IA consomme d’importantes ressources en énergie et en données, ce qui pose des questions environnementales et de souveraineté numérique.

Ces avantages et limites montrent que l’IA est à la fois un outil puissant et un sujet complexe, qui exige une approche réfléchie et encadrée.

L’IA désigne la capacité d’un système informatique ou d’un programme à effectuer des tâches qui nécessitent normalement l’intelligence humaine, comme comprendre un texte, reconnaître une image ou prendre une décision.

Non. L’IA ne « pense » pas au sens humain. Elle traite des données en suivant des modèles statistiques ou des règles définies, sans conscience ni compréhension réelle.

L’IA est utilisée dans de nombreux domaines : santé (diagnostic), finance (détection de fraude), marketing (personnalisation), transports (véhicules autonomes), industrie (maintenance prédictive), services publics (gestion des réseaux), et même dans notre vie quotidienne (assistants vocaux, recommandations).

L’IA faible (ou étroite) est conçue pour une tâche spécifique (ex : traduction automatique, reconnaissance d’image). L’IA forte (ou générale) est un concept théorique qui désigne une machine capable d’apprendre et de s’adapter à tout type de tâche, comme le ferait un humain.

Le machine learning est un sous-ensemble de l’IA où les systèmes apprennent à partir de données. Le deep learning est une forme avancée de machine learning, utilisant des réseaux de neurones artificiels pour traiter des données complexes.

L’IA peut automatiser certaines tâches, mais elle crée aussi de nouveaux métiers et transforme les compétences requises. Le défi est de s’adapter à ces évolutions et d’encadrer l’IA pour qu’elle bénéficie à tous.

Tout dépend de l’usage et des précautions prises. L’IA bien encadrée, avec des données de qualité et une supervision humaine, peut être un outil fiable. Mais il est essentiel de garantir sa transparence, de surveiller les biais et de protéger les données.

Pour approfondir, vous pouvez consulter :

Wikipedia – Intelligence artificielle

Stanford AI Index Report

Articles du New York Times, Nature, Science sur les avancées récentes en IA.

L’Intelligence Artificielle n’est pas qu’un concept théorique ou un mot à la mode. C’est une réalité concrète qui transforme déjà notre quotidien, nos métiers et nos sociétés. Derrière les algorithmes et les modèles d’apprentissage, l’IA est avant tout un outil au service de l’humain, capable de simplifier des tâches, d’optimiser des processus, de favoriser l’innovation et, dans certains cas, de résoudre des défis majeurs.

Mais cette transformation ne va pas sans poser de questions fondamentales. Transparence des algorithmes, biais des données, respect de la vie privée, consommation énergétique : autant de sujets cruciaux qui exigent une approche responsable et éthique. L’IA n’est ni bonne ni mauvaise en soi : tout dépend de l’usage que nous en faisons, et des garde-fous que nous mettons en place.

En comprenant les bases de l’IA, ses mécanismes, ses applications et ses enjeux, nous pouvons mieux appréhender le monde qui se dessine et préparer l’avenir du travail, de l’économie et de la société. Car l’IA est déjà là, et c’est à nous de décider comment elle s’intégrera à notre quotidien.